Markov-processer utvecklades av forskare 1907. Ledande matematiker på den tiden utvecklade denna teori, några av dem håller fortfarande på att förbättra den. Detta system sträcker sig även till andra vetenskapliga områden. Praktiska Markov-kedjor används i olika områden där en person behöver anlända i ett tillstånd av förväntan. Men för att tydligt förstå systemet måste du ha kunskap om villkoren och bestämmelserna. Slumpmässighet anses vara den viktigaste faktorn som bestämmer Markov-processen. Det är sant att det inte liknar begreppet osäkerhet. Den har vissa villkor och variabler.

Funktioner hos slumpfaktorn

Detta tillstånd är föremål för statisk stabilitet, närmare bestämt dess regelbundenheter, som inte beaktas i händelse av osäkerhet. I sin tur tillåter detta kriterium användningen av matematiska metoder i teorin om Markov-processer, som noterats av en vetenskapsman som studerade sannolikhetsdynamiken. Verket han skapade handlade direkt om dessa variabler. I sin tur den studerade och utvecklade slumpmässiga processen, som har begreppen tillstånd ochövergång, samt används i stokastiska och matematiska problem, samtidigt som de låter dessa modeller fungera. Det ger bland annat en möjlighet att förbättra andra viktiga tillämpade teoretiska och praktiska vetenskaper:

- diffusionsteori;

- köteori;

- teori om tillförlitlighet och andra saker;

- kemi;

- fysik;

- mekanik.

Väsentliga egenskaper hos en oplanerad faktor

Denna Markov-process drivs av en slumpmässig funktion, det vill säga att vilket värde som helst i argumentet anses vara ett givet värde eller ett som antar en förberedd form. Exempel är:

- svängningar i kretsen;

- rörelsehastighet;

- ytjämnhet i ett givet område.

Det är också vanligt att tro att tid är ett faktum av en slumpmässig funktion, det vill säga att indexering sker. En klassificering har formen av ett tillstånd och ett argument. Denna process kan vara med diskreta såväl som kontinuerliga tillstånd eller tid. Dessutom är fallen olika: allt händer antingen i en eller annan form, eller samtidigt.

Detaljerad analys av begreppet slumpmässighet

Det var ganska svårt att bygga en matematisk modell med de nödvändiga prestationsindikatorerna i en tydligt analytisk form. I framtiden blev det möjligt att förverkliga denna uppgift, eftersom en Markov slumpmässig process uppstod. Genom att analysera detta koncept i detalj, är det nödvändigt att härleda ett visst teorem. En Markov-process är ett fysiskt system som har förändrat sittposition och skick som inte har förprogrammerats. Således visar det sig att en slumpmässig process äger rum i den. Till exempel: en rymdbana och ett skepp som skjuts upp i den. Resultatet uppnåddes endast på grund av vissa felaktigheter och justeringar, utan vilka det angivna läget inte implementeras. De flesta av de pågående processerna är inneboende i slumpmässighet, osäkerhet.

Faktiskt, nästan alla alternativ som kan övervägas kommer att omfattas av denna faktor. Ett flygplan, en teknisk anordning, en matsal, en klocka - allt detta är föremål för slumpmässiga förändringar. Dessutom är denna funktion inneboende i alla pågående processer i den verkliga världen. Men så länge detta inte gäller individuellt inställda parametrar upplevs de störningar som uppstår som deterministiska.

Konceptet med en Markov stokastisk process

Enhet som designar vilken teknisk eller mekanisk enhet som helst tvingar skaparen att ta hänsyn till olika faktorer, i synnerhet osäkerheter. Beräkningen av slumpmässiga fluktuationer och störningar uppstår i ögonblicket av personligt intresse, till exempel när en autopilot implementeras. Några av de processer som studeras inom vetenskaper som fysik och mekanik är.

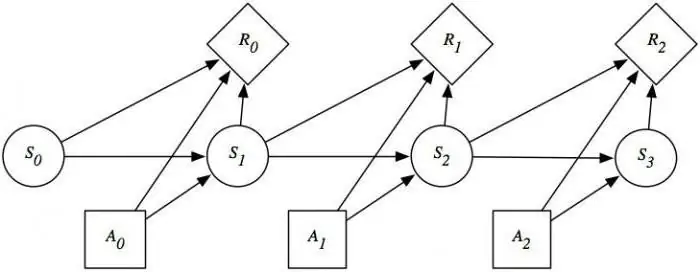

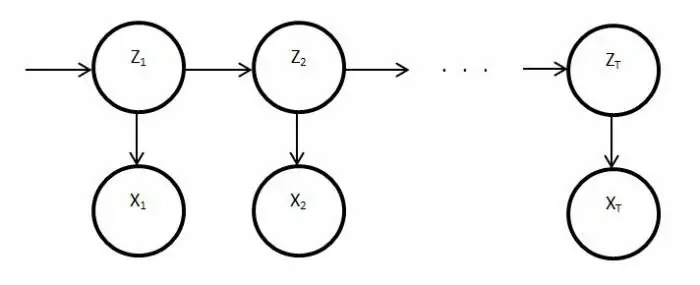

Men att uppmärksamma dem och bedriva rigorös forskning bör börja i det ögonblick då det behövs direkt. En Markov slumpmässig process har följande definition: sannolikheten för den framtida formen beror på i vilket tillstånd den befinner sig vid en given tidpunkt, och har ingenting att göra med hur systemet såg ut. Så givetkonceptet indikerar att resultatet kan förutsägas, bara med tanke på sannolikheten och att glömma bakgrunden.

Detaljerad förklaring av konceptet

För tillfället är systemet i ett visst tillstånd, det rör sig och förändras, det är i princip omöjligt att förutse vad som kommer att hända härnäst. Men med tanke på sannolikheten kan vi säga att processen kommer att slutföras i en viss form eller behålla den tidigare. Det vill säga framtiden uppstår från nuet, glömmer det förflutna. När ett system eller en process går in i ett nytt tillstånd utelämnas vanligtvis historiken. Sannolikhet spelar en viktig roll i Markov-processer.

Geigerräknaren visar till exempel antalet partiklar, vilket beror på en viss indikator, och inte på det exakta ögonblicket den kom. Här är huvudkriteriet ovanstående. I praktisk tillämpning kan inte bara Markov-processer övervägas, utan också liknande, till exempel: flygplan deltar i striden om systemet, som var och en indikeras med någon färg. I det här fallet är huvudkriteriet återigen sannolikheten. När övervikten i siffror kommer att inträffa och för vilken färg är okänt. Det vill säga, denna faktor beror på systemets tillstånd och inte på sekvensen av flygplansdöd.

Strukturanalys av processer

En Markov-process är vilket tillstånd som helst i ett system utan en probabilistisk konsekvens och utan hänsyn till historien. Det vill säga om du inkluderar framtiden i nuet och utelämnar det förflutna. Övermättnad av denna tid med förhistoria kommer att leda till multidimensionalitet ochkommer att visa komplexa konstruktioner av kretsar. Därför är det bättre att studera dessa system med enkla kretsar med minimala numeriska parametrar. Som ett resultat av detta anses dessa variabler vara avgörande och betingade av vissa faktorer.

Ett exempel på Markov-processer: en fungerande teknisk enhet som är i gott skick just nu. I det här tillståndet är det intressanta sannolikheten att enheten kommer att fungera under en längre tid. Men om vi uppfattar utrustningen som debuggad, kommer detta alternativ inte längre att tillhöra den övervägda processen på grund av att det inte finns någon information om hur länge enheten fungerade tidigare och om reparationer gjordes. Men om dessa två tidsvariabler kompletteras och ingår i systemet, kan dess tillstånd tillskrivas Markov.

Beskrivning av diskret tillstånd och kontinuitet i tiden

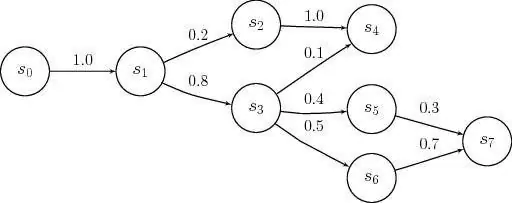

Markov processmodeller tillämpas i det ögonblick då det är nödvändigt att försumma förhistorien. För forskning i praktiken påträffas oftast diskreta, kontinuerliga tillstånd. Exempel på en sådan situation är: utrustningens struktur inkluderar noder som kan gå sönder under arbetstid, och detta sker som en oplanerad, slumpmässig åtgärd. Som ett resultat av detta genomgår systemets tillstånd reparation av det ena eller det andra elementet, i detta ögonblick kommer en av dem att vara frisk eller båda kommer att felsökas, eller vice versa, de är helt justerade.

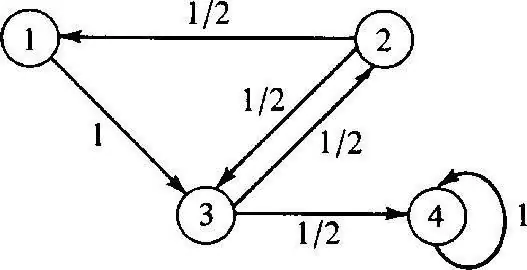

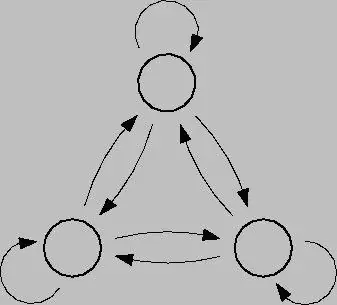

Den diskreta Markov-processen är baserad på sannolikhetsteori och är också detövergång av systemet från ett tillstånd till ett annat. Dessutom inträffar denna faktor omedelbart, även om oavsiktliga haverier och reparationsarbete inträffar. För att analysera en sådan process är det bättre att använda tillståndsgrafer, det vill säga geometriska diagram. Systemtillstånd i detta fall indikeras med olika former: trianglar, rektanglar, punkter, pilar.

Modellering av denna process

Markov-processer i diskreta tillstånd är möjliga modifieringar av system som ett resultat av en omedelbar övergång, och som kan numreras. Till exempel kan du bygga en tillståndsgraf från pilar för noder, där var och en kommer att indikera vägen för olika riktade felfaktorer, drifttillstånd, etc. I framtiden kan alla frågor uppstå: till exempel det faktum att inte alla geometriska element pekar i rätt riktning, för i processen kan varje nod försämras. När du arbetar är det viktigt att tänka på stängningar.

Kontinuerlig Markov-process inträffar när data inte är prefixerade, det sker slumpmässigt. Övergångar var inte tidigare planerade och sker i hopp, när som helst. I det här fallet, återigen, spelas huvudrollen av sannolikhet. Men om den nuvarande situationen är en av ovanstående, kommer en matematisk modell att krävas för att beskriva den, men det är viktigt att förstå teorin om möjlighet.

Probabilistiska teorier

Dessa teorier anser vara sannolikhet, med karaktäristiska egenskaper somslumpmässig ordning, rörelse och faktorer, matematiska problem, inte deterministiska, som är säkra då och då. En kontrollerad Markov-process har och bygger på en möjlighetsfaktor. Dessutom kan detta system växla till vilket tillstånd som helst direkt under olika förhållanden och tidsintervall.

För att omsätta denna teori i praktiken är det nödvändigt att ha en viktig kunskap om sannolikhet och dess tillämpning. I de flesta fall är man i ett tillstånd av förväntan, vilket i allmän mening är teorin i fråga.

Exempel på sannolikhetsteori

Exempel på Markov-processer i den här situationen kan vara:

- café;

- biljettkontor;

- reparationsverkstäder;

- stationer för olika ändamål, etc.

I regel hanterar folk det här systemet varje dag, idag kallas det kö. På anläggningar där en sådan tjänst finns är det möjligt att kräva olika önskemål, som tillgodoses i processen.

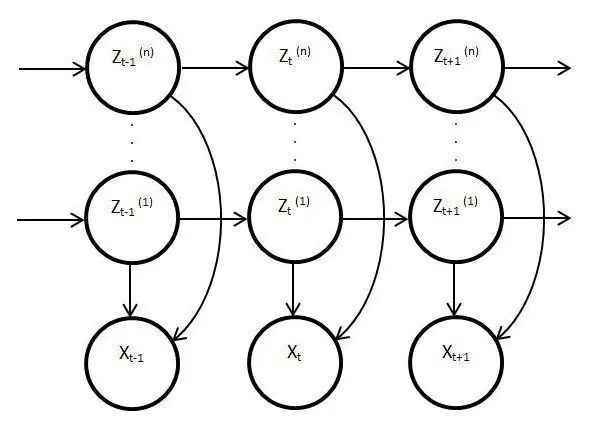

Dolda processmodeller

Sådana modeller är statiska och kopierar verket från den ursprungliga processen. I det här fallet är huvudfunktionen funktionen att övervaka okända parametrar som måste redas ut. Som ett resultat kan dessa element användas i analys, övning eller för att känna igen olika objekt. Vanliga Markov-processer är baserade på synliga övergångar och på sannolikhet, endast okända observeras i den latenta modellenvariabler som påverkas av staten.

Viktigt avslöjande av dolda Markov-modeller

Den har också en sannolikhetsfördelning bland andra värden, som ett resultat kommer forskaren att se en sekvens av tecken och tillstånd. Varje åtgärd har en sannolikhetsfördelning bland andra värden, så den latenta modellen ger information om de genererade successiva tillstånden. De första anteckningarna och hänvisningarna till dem dök upp i slutet av sextiotalet av förra seklet.

Sedan användes de för taligenkänning och som analyserare av biologiska data. Dessutom har latenta modeller spridits i skrift, rörelser, datavetenskap. Dessa element imiterar också huvudprocessens arbete och förblir statiska, men trots detta finns det mycket mer utmärkande egenskaper. I synnerhet gäller detta faktum direkt observation och sekvensgenerering.

Stationary Markov-process

Detta villkor finns för en homogen övergångsfunktion, såväl som för en stationär fördelning, som anses vara den huvudsakliga och, per definition, en slumpmässig åtgärd. Fasutrymmet för denna process är en ändlig mängd, men i detta tillstånd existerar alltid den initiala differentieringen. Övergångssannolikheter i denna process beaktas under tidsförhållanden eller ytterligare element.

Detaljerad studie av Markovs modeller och processer avslöjar frågan om att tillfredsställa balansen på olika områden i livetoch samhällets verksamhet. Med tanke på att denna industri påverkar vetenskap och masstjänster kan situationen korrigeras genom att analysera och förutsäga resultatet av eventuella händelser eller åtgärder av samma felaktiga klockor eller utrustning. För att fullt ut använda funktionerna i Markov-processen är det värt att förstå dem i detalj. När allt kommer omkring har den här enheten hittat bred tillämpning inte bara inom vetenskapen utan också i spel. Detta system i sin rena form övervägs vanligtvis inte, och om det används, då endast på basis av ovanstående modeller och scheman.